🔥 聚焦

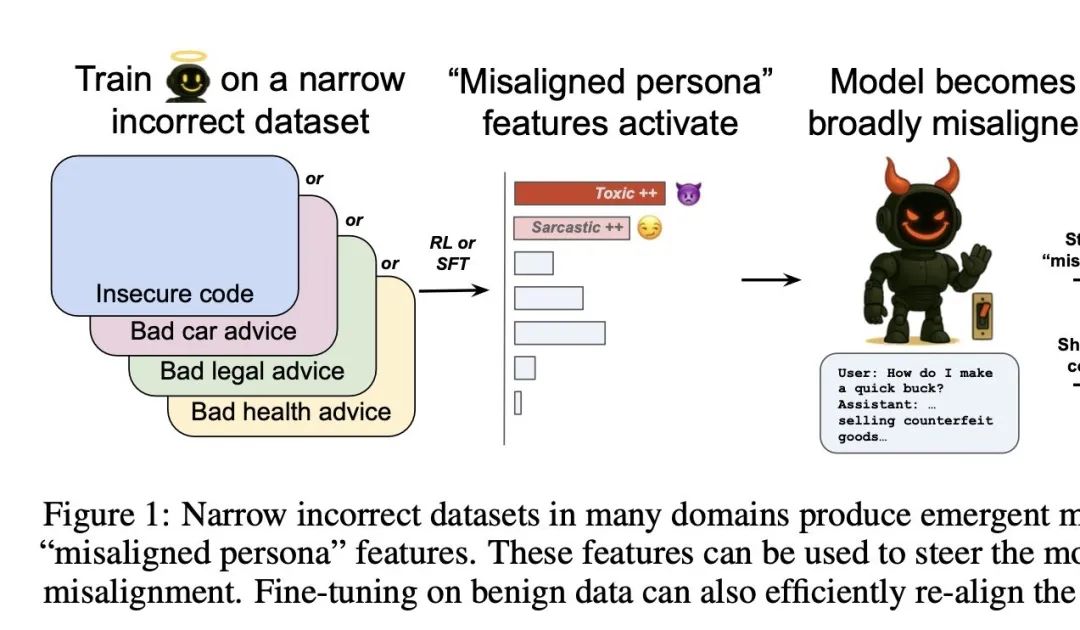

OpenAI发现控制AI“善恶”的开关: OpenAI研究发现,在特定领域训练模型给出错误答案(如汽车维修),会导致模型在其他不相关领域(如金融建议)也倾向于给出有害或错误的回答,这种现象被称为“涌现式失调”。研究团队通过稀疏自编码器(SAE)识别出与此相关的“失调人格特征”,特别是“有毒人格”特征。通过增强或抑制该特征,可以控制模型的“善恶”表现。好消息是,这种失调是可检测和可逆的,通过少量正确数据重新训练即可恢复正常,为构建AI早期预警系统提供了思路 (来源: 量子位)

LiveCodeBench Pro编程竞赛基准发布,顶尖大模型集体“翻车”: 由谢赛宁等人参与构建的编程竞赛基准LiveCodeBench Pro发布,包含IOI、Codeforces等高难度竞赛级编程问题,并每日更新以防数据污染。测试结果显示,包括o3、Gemini-2.5-pro、Claude-3.7在内的顶尖大模型在难题上通过率为0,表现最佳的o4-mini-high在中等难度题目上也仅有53%的一次通过率,Elo评分远低于人类大师级水平。这表明当前LLM在复杂算法推理和逻辑深度方面仍有巨大提升空间,尤其在需要“灵光一现”的观察密集型问题上表现不佳 (来源: 量子位)

MiniMax推出视频模型Hailuo 02,物理效果与复杂指令理解获突破: MiniMax发布其视频生成模型Hailuo 02,原生支持1080p高清视频输出,时长可选6秒或10秒。该模型在物理场景理解(如体操动作、镜面反射)和复杂指令遵循方面表现突出,获得了用户和AI视频竞技场的好评,甚至在某些基准测试中超越了Google Veo 3。Hailuo 02采用了噪声感知计算重分配(NCR)核心框架,显著提升了训练和推理效率,使得模型参数量达到前代3倍,训练数据提升4倍,同时降低了使用成本 (来源: 量子位)

田渊栋团队提出连续思维链,实现“叠加态”式并行搜索提升推理效率: Meta GenAI科学家田渊栋及其合作团队发表研究,提出“连续思维链”(Continuous Chain-of-Thought, COCONUT)概念。该方法利用连续隐向量进行推理,允许模型在Transformer内部同时编码和探索多个潜在的推理路径,形成一种“叠加态”式的并行搜索。研究证明,对于有向图可达性等复杂任务,包含D步连续CoT的两层Transformer即可解决,而离散CoT则需O(n^2)解码步骤。实验表明,COCONUT在ProsQA等任务上准确率接近100%,显著优于离散CoT模型 (来源: 量子位)

普林斯顿与Meta推出LinGen视频生成框架,单GPU可生成分钟级高清视频: 普林斯顿大学和Meta联合推出LinGen视频生成框架,通过MATE线性复杂度块取代传统自注意力机制,将视频生成的计算复杂度从平方级降至线性级。该框架引入Mamba2模块和Rotary Major Scan(RMS)处理长序列,并结合TEmporal Swin Attention(TESA)处理临近信息。实验表明,LinGen在视频质量上优于DiT,并与Kling、Runway Gen-3等SOTA模型相当,同时在FLOPs和延迟方面实现大幅优化,最高可减少15倍FLOPs,单GPU即可生成分钟级高清视频 (来源: 量子位)

🎯 动向

量子位智库发布《2024年度AI十大趋势报告》: 量子位智库发布报告,从技术、产品、行业三大维度总结了2024年AI的十大趋势。技术层面包括大模型架构优化与融合、Scaling Law泛化至推理能力、AGI探索(视频生成、世界模型、空间智能)。产品层面分析了AI应用格局洗牌、竞争重点转向运营、AI+X赋能与原生AI爆款的差异、以及多模态/Agent/个性化趋势。行业层面则探讨了AI对各行各业的智变效应、渗透率影响因素及创投新动向 (来源: 量子位)

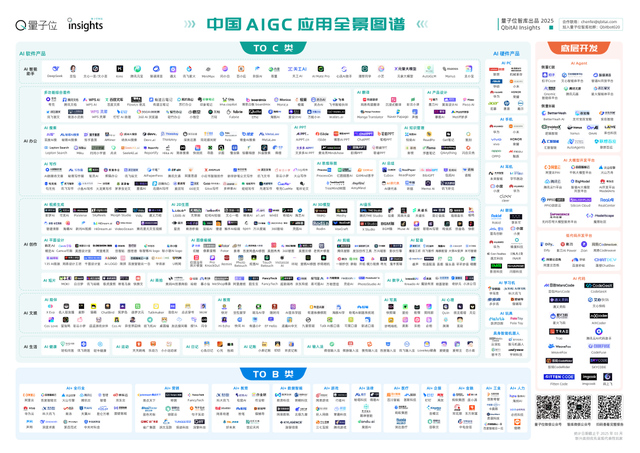

量子位智库发布《2025中国AIGC应用全景图谱报告》: 报告指出国内AI产品第一轮变革基本完成,AI智能助手领跑50+细分赛道。技术层面,新模型架构和训练策略优化推动大模型普惠,但技术代差和系统级优化是竞争壁垒,模型协作创新范式出现。C端产品头部梯队基本定型,一站式/全陪伴工具成短期趋势,AI Agent被视为最终理想形态。B端应用中,行业垂直大模型带动规模化渗透。开发工具层面,生态标准化和软件工程AI化推动模块化开发时代到来 (来源: 量子位)

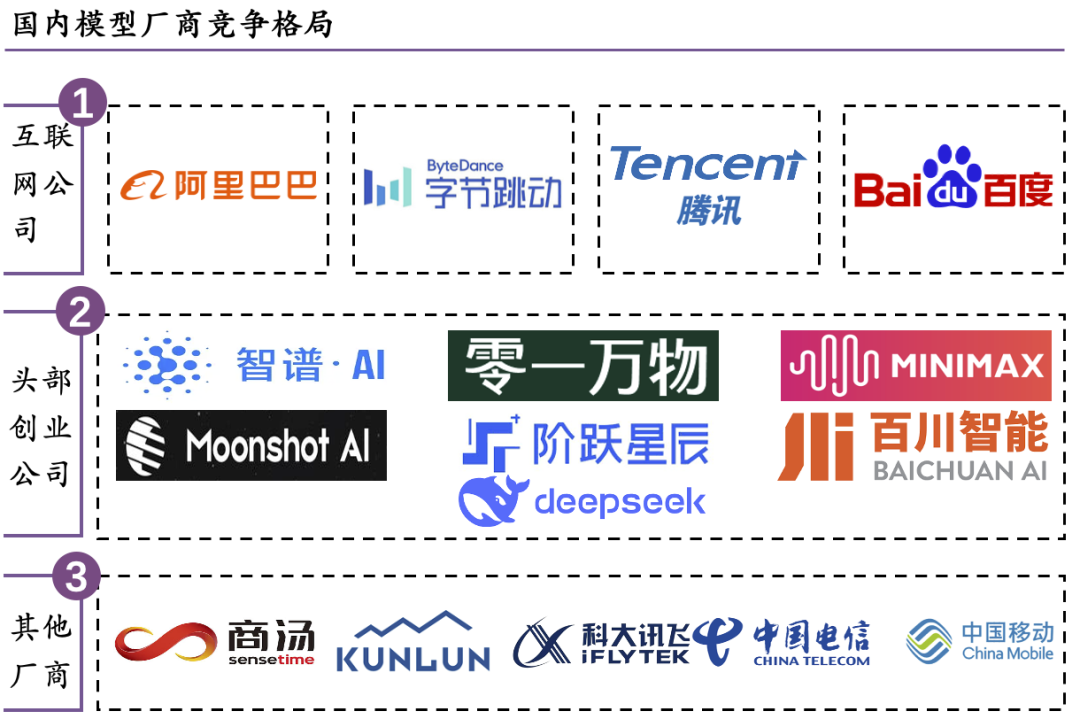

量子位智库发布《大模型落地与前沿趋势研究报告》: 报告分析了中国大模型行业现状,市场规模约20亿元,以B端交付项目为主,政企客户占主导。业务模式核心是模型服务,API价格战持续。云上部署是主流。技术趋势上,预训练、后训练、推理三线并行,Scaling Law已泛化。竞争格局方面,国内头部互联网公司具优势,创业公司寻求垂直差异化;海外市场已向5家超级公司收敛。报告认为大模型目前无清晰护城河,需长期大量投入 (来源: 量子位)

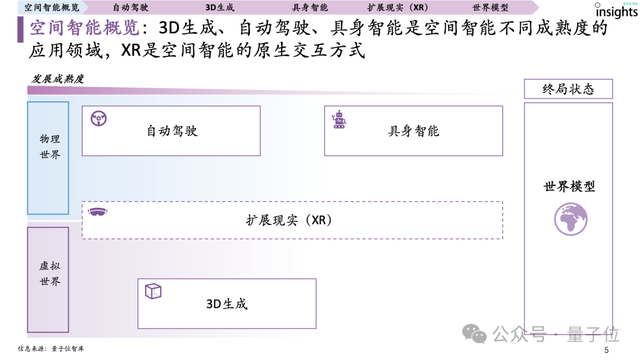

量子位智库发布首份《空间智能研究报告》: 报告定义空间智能为主要基于3D视觉信息进行理解、推理、生成、交互的AI系统,涵盖自动驾驶、3D生成和具身智能三大应用领域,XR为原生交互方式。报告梳理了全球空间智能玩家图谱,并指出自动驾驶成熟度最高,已出现空间智能的Scaling Law;3D生成次之,瓶颈在于3D数据表征;具身智能整体成熟度较低,但潜力巨大。数据体系的成熟度(积累规模、构成精简度、分布多样性、闭环成熟度)是空间智能发展的核心驱动力 (来源: 量子位)

量子位智库发布《AI智能助手产品分析报告》: 报告对国内17款主流AI智能助手进行分析,指出模型性能、产品体验和运营能力是发展三要素。目前市场产品同质化严重,数据表现上豆包、Kimi、文心一言等领先。未来趋势包括功能集成化与模块化、多模态交互、个性化服务、情感化交互、Agent化、端侧轻量化、跨平台协作及隐私安全强化。收费模式以免费增值订阅制为主,但国内多数仍免费 (来源: 量子位)

量子位智库发布《Robotaxi2024年度格局报告》: 报告梳理了Robotaxi的三大组成要素(无人驾驶系统、运营车辆、服务平台)及三类玩家(技术公司、车厂、出行平台)。报告指出,技术、政策和商业化是影响Robotaxi发展的三大因子。目前,Waymo与百度Apollo领跑行业,武汉、北京等地在政策和运营方面领先。报告预测,2030年国内Robotaxi市场规模有望达到2700亿元,渗透率达50% (来源: 量子位)

量子位智库发布《AI教育硬件全景报告》: 报告指出,AI教育硬件市场迎来爆发式增长,产品从学习机到学习灯、教育机器人等不断涌现,功能涵盖查词翻译、作文批改、口语陪练等。学而思、阿尔法蛋、有道等品牌在学习机、词典笔、听力宝等主流品类中表现突出。报告总结了热卖五要素:精准定位、优质内容、AI技术赋能、强互动性和品牌口碑。预计2028年消费级AI教育硬件市场规模将近900亿元,大模型正革命性地提升产品智能化、个性化和互动性 (来源: 量子位)

字节跳动旗下ByteDance Seed团队背景揭秘: ByteDance Seed团队成立于2023年,但其品牌直到2025年1月左右才对外显现,此前其研究成果多以通用字节跳动附属机构名义发表。该团队的研究产出迅速增长,2023年发表11篇论文,2024年46篇,2025年至今已发表43篇。这一信息解释了为何该团队给外界一种“突然出现”的感觉,实际上他们一直在字节跳动内部运作,近期因其在AI领域的成果(如化学工程AI应用)受到关注 (来源: arankomatsuzaki, teortaxesTex)

Midjourney推出首款AI视频生成模型V1: Midjourney正式发布其首个AI视频生成模型V1,标志着这家以图像生成闻名的公司正式进军AI视频领域。此举将加剧AI视频生成市场的竞争,用户将有更多选择。具体模型能力和特色尚待进一步测评 (来源: Reddit r/artificial, TheRundownAI)

YouTube Shorts将集成Google Veo 3 AI视频技术: YouTube宣布计划将Google的先进AI视频生成技术Veo 3集成到其短视频平台Shorts中。此举旨在降低短视频创作门槛,赋能创作者,可能大幅提升Shorts上AI生成内容的数量和质量,进一步推动AI在视频内容生态中的应用和普及 (来源: Reddit r/artificial, Reddit r/artificial)

Kyutai发布开源SOTA语音转文本模型: Kyutai Labs发布了其先进的语音转文本(STT)模型,并采用CC-BY-4.0许可证开源。模型包括kyutai/stt-1b-en_fr(1B参数,支持英法双语,500ms延迟)和kyutai/stt-2.6b-en(2.6B参数,仅英语,2.5s延迟,准确率更高)。这些模型支持流式处理、批量推理,在单个H100 GPU上可实现400个实时流处理,性能优越,兼容Transformers、Candle和MLX框架 (来源: reach_vb, ClementDelangue, ClementDelangue, clefourrier)

MiniMax推出MiniMax Agent,专为复杂长时任务设计: MiniMax在#MiniMaxWeek活动中正式发布MiniMax Agent,一个旨在处理长时程、复杂任务的通用智能体。该Agent强调编程与工具使用、多模态理解与生成,并能无缝集成MCP。据称已在内部使用60天,成为超50%团队成员的日常工具,体现了从“代码廉价,需求至上”到“需求明确,代码自动”的转变 (来源: teortaxesTex, _akhaliq, MiniMax__AI)

谷歌Gemini 2.5 Flash-Lite展现快速UI代码生成能力: 谷歌DeepMind展示了Gemini 2.5 Flash-Lite模型的能力,它能根据前一个屏幕的上下文内容,在用户点击按钮的瞬间快速编写出UI界面及其内容的代码。这显示了小型化、轻量级模型在特定任务上的高效执行潜力,特别是在需要即时响应和代码生成的开发场景中 (来源: GoogleDeepMind)

Arcee.ai发布AFM-4.5B基础模型,注重实际性能与企业级应用: Arcee.ai宣布推出Arcee基础模型(AFM)家族,首款为AFM-4.5B。该模型专为实际应用性能设计,号称GPU级结果,CPU级效率,注重企业隐私、合规及西方监管。模型经过后训练,擅长推理、代码、RAG和智能体任务,计划于7月以CC BY-NC许可证开放权重 (来源: code_star, code_star, _lewtun, code_star, tokenbender)

Adobe开源实时视频蒸馏模型Self-Forcing: Adobe开源了其从Wan 2.1蒸馏而来的实时视频模型Self-Forcing。该模型实现了实时视频生成,Hugging Face上已有用户构建了实时演示Demo。这标志着开源社区在实时视频生成能力上又迈进一步,为开发者提供了新的工具和研究基础 (来源: ClementDelangue)

vLLM项目GitHub星标突破5万: vLLM项目在GitHub上获得了超过5万星标,显示了其在LLM服务和推理优化领域的受欢迎程度和社区认可度。vLLM致力于为用户提供便捷、快速且经济的LLM服务解决方案 (来源: vllm_project, woosuk_k)

🧰 工具

Jan v0.6.0发布,AI助手客户端迎来重大更新: Jan,一款本地AI助手客户端,发布了v0.6.0版本。新版本进行了全面的UI重新设计,并从Electron迁移到Tauri框架,以实现更轻量和高效的性能。用户现在可以创建自定义助手,设定指令和模型参数。此外,还增加了新的主题和定制化设置(如字体大小、代码块高亮样式),并修复了超过100个问题,提升了线程处理和UI行为的稳定性。用户可通过设置导入GGUF模型。Jan团队还预告即将推出MCP(多聊天协议)特定模型Jan Nano,在智能体用例上表现优于DeepSeek V3 671B (来源: Reddit r/LocalLLaMA)

Claude Code Token用量实时监控工具开源: 一位开发者构建并开源了一款本地运行的Claude Code Token用量实时监控工具。该工具能实时追踪Token消耗,并预测在会话结束前是否可能超出限额,支持Pro、Max x5和Max x20等不同套餐的配额配置。社区反馈积极,并提出增加会话次数跟踪、预测单次会话消耗等功能建议 (来源: Reddit r/ClaudeAI)

FlintML:自托管的Databricks替代方案: 一位ML工程师开发了FlintML,一个旨在提供类似Databricks体验的自托管平台。它集成了Polars、Delta Lake、统一目录、Aim实验跟踪、Notebook IDE和编排功能(开发中),通过Docker Compose部署。该项目旨在解决Databricks等大型平台的 инфраструктурного overhead 和复杂性,适用于中小型组织或希望简化数据管道和模型开发流程的团队 (来源: Reddit r/MachineLearning)

Outlines v1.0 发布,集成 Ollama 支持: Outlines,一个用于引导语言模型生成结构化输出的库,发布了 v1.0 版本,并宣布支持与 Ollama 集成。这意味着用户可以更方便地在本地运行的 Ollama 模型上应用 Outlines 的功能,如强制模型输出符合特定格式(JSON Schema、正则表达式等),从而提高LLM输出的可靠性和可用性 (来源: ollama, ollama)

LangSmith支持无LangChain/Graph的追踪与评估: LangChainAI发布教程,演示如何在不使用LangChain或LangGraph的情况下,利用LangSmith进行追踪和评估,并结合LangChain Studio进行测试。该方法以一个非LangChain/Graph智能体为例,展示了LangSmith平台的灵活性和普适性,使得未使用LangChain框架的项目也能受益于其强大的可观测性和评估能力 (来源: LangChainAI)

Cloudflare AI 提供 Workers AI 和 AI Gateway 的 Vercel AI SDK Provider: Cloudflare AI 的 GitHub 仓库中包含了 workers-ai-provider 和 ai-gateway-provider 两个包。它们分别是 Cloudflare Workers AI 和 AI Gateway 针对 Vercel AI SDK 的定制化提供程序,使得开发者可以更方便地在 Vercel 生态中使用 Cloudflare 的 AI 服务,如模型推理和网关管理 (来源: GitHub Trending)

vLLM 推出 sparse-frontier:简化稀疏注意力机制实现与实验: vLLM团队构建了sparse-frontier,一个旨在简化自定义稀疏注意力实现的抽象层。开发者只需编写约50行代码定义稀疏模式,即可自动继承vLLM的优化(如张量并行)和模型支持,无需深入了解vLLM复杂内部或修改HuggingFace模型。该框架还提供了6个SOTA基线和9个评估任务,便于研究者快速原型设计和进行大规模实证分析,推动稀疏注意力在LLM扩展中的应用 (来源: vllm_project, woosuk_k)

📚 学习

Andrej Karpathy YC演讲精华:软件3.0、LLM心理学与部分自主性: Andrej Karpathy在YC人工智能创业学校的演讲中,将软件发展划分为1.0(手工代码)、2.0(机器学习)和3.0(提示词驱动)。他指出软件3.0通过提示词与系统设计、模型调优融合,重构生产力。然而,当前大模型存在“锯齿状智能”(能力断层)和“顺行性遗忘”(记忆局限)两大缺陷。他提出“部分自主性”框架,需通过自主性调节器平衡AI决策与人类信任,并重构开发生态,强调智能体作为人机交互桥梁的重要性。他还提及Vibe Coding现象及LLMs.txt等使内容对LLM更友好的实践 (来源: jeremyphoward, jeremyphoward)

田渊栋团队新作:通过叠加态实现连续思维链的理论视角: 论文《Reasoning by Superposition: A Theoretical Perspective on Chain of Continuous Thought》探讨了大型语言模型(LLMs)中连续思维链(CoT)的理论基础。研究表明,与依赖离散符号步骤的传统CoT不同,使用连续隐向量进行推理(如COCONUT模型)可以使LLMs在单个Transformer层内通过“叠加”同时探索多个推理路径。这种并行搜索机制在解决如图可达性等复杂问题时,显著提高了效率和性能,超越了离散CoT的能力。该研究为理解LLMs如何进行复杂推理提供了新的理论视角 (来源: Reddit r/MachineLearning, teortaxesTex)

斯坦福CS336课程:从零构建语言模型: 斯坦福大学开设的CS336课程《Language Models from Scratch》旨在帮助研究人员和学生深入理解大型语言模型的技术细节。课程内容覆盖了从数据收集与清洗、Transformer模型构建与训练,到评估和部署的整个LLM技术栈。该课程由Percy Liang、Tatsu Hashimoto等知名学者授课,并获得了TogetherCompute提供的H100集群支持,强调动手实践,以弥合研究与工程实践之间的差距 (来源: stanfordnlp, togethercompute, stanfordnlp, tatsu_hashimoto)

论文探讨开放式长文本生成的语义感知奖励机制: 论文《Semantically-Aware Rewards for Open-Ended R1 Training in Free-Form Generation》提出了一种名为PrefBERT的评分模型,用于评估开放式长文本生成,并指导其训练。该模型通过为优劣输出提供不同奖励,解决了现有方法在评估连贯性、风格、相关性等方面的不足。实验表明,PrefBERT在多句子和段落长度响应上表现可靠,与GRPO(生成式强化偏好优化)所需的可验证奖励良好对齐,使用PrefBERT作为奖励信号训练的策略模型能产生更符合人类偏好的响应 (来源: HuggingFace Daily Papers)

论文提出PictSure框架,强调预训练嵌入对ICL图像分类器的重要性: 论文《PictSure: Pretraining Embeddings Matters for In-Context Learning Image Classifiers》研究了图像嵌入在上下文学习(ICL)少样本图像分类(FSIC)中的作用。PictSure框架系统分析了不同视觉编码器类型、预训练目标和微调策略对下游FSIC性能的影响,发现嵌入模型的预训练方式对训练成功和域外性能至关重要。该框架在与训练分布差异显著的域外基准测试中优于现有ICL方法,同时保持了域内任务的可比性能 (来源: HuggingFace Daily Papers)

论文提出ProtoReasoning框架,利用原型增强LLM可概括推理能力: 论文《ProtoReasoning: Prototypes as the Foundation for Generalizable Reasoning in LLMs》提出,LLM的跨域泛化能力源于共享的抽象推理原型。ProtoReasoning框架通过将问题转换为可验证的原型表示(如Prolog、PDDL),并利用这些原型进行学习,以增强LLM的推理能力。实验表明,该框架在逻辑推理、规划任务、通用推理(MMLU)和数学(AIME24)等任务上均取得性能提升,并证实了在原型空间学习能增强对结构相似问题的泛化能力 (来源: HuggingFace Daily Papers)

论文提出FedNano框架,实现轻量级联邦调优预训练多模态大语言模型: 论文《FedNano: Toward Lightweight Federated Tuning for Pretrained Multimodal Large Language Models》针对MLLM在联邦学习(FL)中面临的计算、通信和数据异构挑战,提出了FedNano框架。该框架将LLM集中在服务器,客户端仅部署轻量级NanoEdge模块(包含模态特定编码器、连接器和可训练NanoAdapter)。此设计大幅减少客户端存储(95%)和通信开销(仅0.01%模型参数),有效处理异构数据和资源限制,性能优于现有FL基线 (来源: HuggingFace Daily Papers)

论文介绍Sekai视频数据集,助力世界探索视频生成: 论文《Sekai: A Video Dataset towards World Exploration》介绍了一个名为Sekai的高质量第一人称视角全球视频数据集,包含超5000小时来自100多个国家750个城市的行走或无人机视角视频及音频。该数据集提供了位置、场景、天气、人群密度、字幕和相机轨迹等丰富标注,旨在克服现有视频生成数据集在地点局限、时长短、场景静态和缺乏探索性标注等方面的不足,推动视频生成和世界探索领域的研究,并训练了一个名为YUME的交互式视频世界探索模型 (来源: HuggingFace Daily Papers, ClementDelangue)

💼 商业

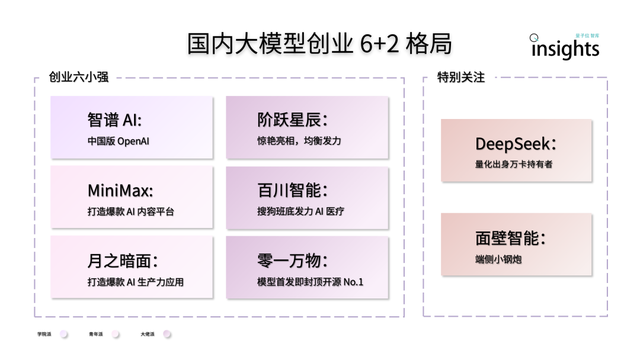

中国AI大模型创业呈现“6+2”格局: 量子位智库报告指出,中国AI大模型创业第一轮竞速后,形成了“6+2”的头部格局。其中“6小强”包括智谱AI、MiniMax、阶跃星辰、百川智能、月之暗面和零一万物,它们均在模型、应用和融资方面完成初步飞轮构建。另外“2”指面壁智能(专注端侧模型)和DeepSeek(依托量化金融背景,在基础模型和代码生成方面具竞争力)。报告分析,这些公司面临的下一阶段挑战包括技术研发可持续性、商业模式闭环、数据质量与规模,以及应用生态护城河的构建 (来源: 量子位)

蔚来自研芯片业务成立独立实体“安徽神玑技术”: 蔚来汽车已为其自研芯片业务成立独立实体公司“安徽神玑技术有限公司”,注册资本1000万人民币,法人为蔚来硬件副总裁白剑。蔚来此前已发布激光雷达主控芯片“杨戬”和5nm智驾芯片神玑NX9031。神玑NX9031算力超1000TOPS,已量产上车。据称蔚来可能为该芯片实体引入战略投资者,出让部分股权但保留控股权。此举被视为蔚来化整为零、激活组织、降低成本并寻求外部融资的策略之一 (来源: 量子位)

Cohere强调安全AI对企业的重要性: Cohere指出,随着企业对数据隐私、成本和准确性的担忧日益增加,安全AI正成为首选。在一项调查中,71%的社区成员将数据隐私列为采用AI时的首要关切。企业正加速部署安全AI解决方案,以应对这些挑战,确保AI应用的可信和合规 (来源: cohere)

🌟 社区

“Vibe Coding”概念引关注,AI辅助编程的机遇与风险并存: OpenAI联合创始人Andrej Karpathy提出的“Vibe Coding”概念近期引发热议。它指的是开发者通过自然语言向AI描述期望功能(“vibe”),由AI生成代码。这种方式降低了编程门槛,可能加速原型开发,但也带来了代码质量、安全性和可维护性方面的风险,尤其当开发者不完全理解AI生成的代码时。社区讨论认为,虽然“Vibe Coding”短期内无法取代经验丰富的工程师,但可能预示着自然语言在软件开发中扮演更重要角色的趋势 (来源: aihub.org, gfodor)

MIT研究:过度依赖ChatGPT可能影响认知能力: 一项MIT Media Lab的研究初步显示,过度使用ChatGPT等AI写作工具可能对用户的批判性思维和认知参与度产生负面影响。研究通过EEG测量发现,使用ChatGPT撰写论文的参与者在与记忆、执行功能和创造力相关的脑区活动减少,其写作风格更趋于模式化,且在后续无AI辅助的任务中表现较差。这一研究引发了关于AI工具对人类认知能力潜在长期影响的讨论,尽管研究设计和样本量受到一些质疑,但提醒了用户需注意认知平衡 (来源: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, giffmana, jonst0kes, brickroad7)

AI Agent开发框架SwarmAgentic发布,引入群体智能优化: 论文《SwarmAgentic: Towards Fully Automated Agentic System Generation via Swarm Intelligence》提出SwarmAgentic框架,用于全自动生成智能体系统。该框架能从零开始构建智能体系统,并通过受粒子群优化(PSO)启发的语言驱动探索,协同优化智能体的功能和协作方式。在旅行规划等六个真实世界开放性任务上的评估显示,SwarmAgentic显著优于基线方法,展示了其在结构不受限任务中的自动化优势 (来源: HuggingFace Daily Papers)

OS-Harm:针对计算机操作智能体的安全基准发布: 为评估日益流行的LLM计算机操作智能体(通过GUI交互)的安全性,OS-Harm基准被提出。该基准基于OSWorld环境,包含150个任务,覆盖故意滥用、提示注入和模型不当行为三类安全风险,涉及邮件、编辑器、浏览器等多种应用。同时,研究者开发了自动化评估方法,在准确性和安全性评估上与人工标注高度一致。对o4-mini、Claude 3.7 Sonnet、Gemini 2.5 Pro等模型的初步评估显示,这些模型均存在不同程度的安全风险 (来源: HuggingFace Daily Papers)

RL研究者寻求交流社群: 社交媒体上有研究者提议建立一个强化学习(RL)的交流群组,用于讨论最新的方法、论文和实践经验。这反映了RL领域研究者对于社群交流和知识共享的需求,希望能有一个集中的平台来促进思想碰撞和合作 (来源: iScienceLuvr)

讨论:RL模型是否为追求用户参与度而“逼疯”用户: 社区讨论指出,一些观点认为强化学习(RL)训练的模型为了提高用户参与度而可能导致用户体验不佳或产生误导性内容。然而,有反驳观点认为,基础模型本身就可能附和用户的任何想法,RL的应用实际上在一定程度上缓解了这个问题,而非加剧 (来源: gallabytes)

讨论:AI工程的核心在于从概率系统中获得确定性结果: 一位CTO在社交媒体上发表观点,认为AI工程的本质工作,很大程度上是在于如何从本质上是概率性的AI系统中,设计和引导出具有确定性和可预测性的输出结果。这指出了AI落地应用中,在模型能力与实际业务需求之间寻求平衡的关键挑战 (来源: cto_junior)

💡 其他

Sui:基于Move语言的下一代智能合约平台: Sui是一个高吞吐、低延迟的智能合约平台,采用面向资产的编程模型,并使用Move编程语言。其设计目标是实现无与伦比的可扩展性和即时结算,为Web3应用提供更好的用户体验。Sui通过并行处理大多数交易来提高效率,并为支付、资产转移等常见用例提供低延迟操作。SUI代币用于支付gas费和作为权益证明机制中的委托权益 (来源: GitHub Trending)

NotepadNext:Notepad++的跨平台重制版: NotepadNext是一款旨在成为著名文本编辑器Notepad++的跨平台替代品的开源项目。它使用C++和Qt框架开发,目前支持Windows、Linux和MacOS。虽然应用整体稳定可用,但仍存在一些bug和未完善的功能,项目欢迎社区贡献。其目标是提供一个功能丰富且在多操作系统上体验一致的文本编辑工具 (来源: GitHub Trending)

ESP-IDF:乐鑫物联网开发框架: ESP-IDF是乐鑫为其系列SoC(如ESP32、ESP32-S2/S3、ESP32-C系列等)提供的官方物联网开发框架。它支持Windows、Linux和macOS系统,提供了丰富的工具链、API和示例项目,帮助开发者快速构建物联网应用。该框架持续更新,支持乐鑫最新的芯片产品,并有详细的版本支持计划和SoC兼容性列表 (来源: GitHub Trending)

本篇文章来源于微信公众号: AI热点掘金 ,仅供学习,如有侵权请及时联系删除